Hasta hace unos años la explicación de cualquier accidente parecía reducirse a un gesto sencillo: culpar al último eslabón visible de la cadena. Un operario distraído, un piloto demasiado confiado, un sanitario que tomó una decisión apresurada. Ese enfoque tenía una ventaja indiscutible: al señalar a una persona, el sistema quedaba absuelto. Era una narrativa cómoda, casi tranquilizadora. Bastaba con identificar al culpable, corregir su error y continuar como si nada hubiera ocurrido.

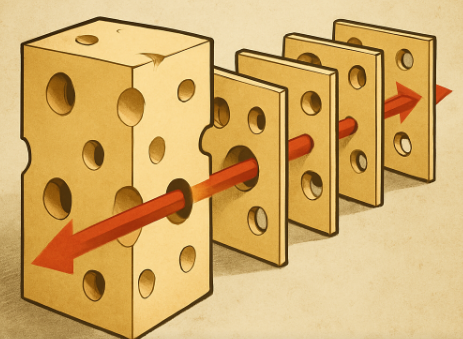

James Reason vino a interrumpir esa comodidad con una idea que, desde la distancia, parece casi evidente: los accidentes no son la consecuencia de un solo fallo, sino la convergencia de múltiples vulnerabilidades distribuidas a lo largo del sistema. Para explicarlo recurrió a una metáfora tan doméstica como irreversible en su impacto: el queso suizo.

Durante décadas, las organizaciones complejas se gobernaron como si fueran relojes: engranajes bien ajustados, movimientos previsibles y la ilusión de que la realidad podía someterse a un manual. Bajo esa premisa, cualquier desvío sólo podía explicarse como una falla humana. El problema era el individuo, no el diseño.

La teoría del “queso suizo” desmontó esa ficción. Reason argumentó que todo sistema dispone de capas de defensa destinadas a impedir que el error se convierta en daño. Sin embargo, ninguna de esas defensas es perfecta. Cada una contiene grietas, huecos microscópicos, pequeñas debilidades latentes. Mientras esos agujeros permanezcan desalineados, el sistema resiste. El riesgo existe, pero está contenido. El desastre llega cuando esos agujeros se alinean, creando un pasillo silencioso que permite al error avanzar sin oposición.

Ese cambio conceptual desplazó la pregunta clásica («¿quién falló?”) hacia otra más incómoda: “¿qué permitió que el fallo progresara?”.

La diferencia no es sólo semántica. Implica aceptar que el error humano no es el origen, sino el síntoma; que el sistema no es un escenario pasivo, sino un actor que puede amplificar o contener las consecuencias del fallo. La mirada se extiende así hacia lo invisible: decisiones administrativas tomadas meses atrás, protocolos confusos, equipos insuficientes, jornadas interminables, silencios convertidos en costumbre.

Cuando se revisan accidentes industriales, eventos sanitarios graves, fallos de infraestructura o incidentes de seguridad, emerge un patrón inquietante. Antes del momento final, ése que suele copar los titulares, existían señales ignoradas, alertas desestimadas o reportes que nunca llegaron a quien debía escucharlos. Las vulnerabilidades estaban allí, dispersas.

La teoría de Reason no invita al fatalismo, sino al aprendizaje. No se limita a señalar el problema; propone un modo distinto de concebir la seguridad. En lugar de confiar en la impecabilidad del individuo, apuesta por sistemas que reduzcan la dependencia del heroísmo. Una organización madura no puede permitirse que una sola acción, o su omisión, determine la diferencia entre un día rutinario y una tragedia. Si eso ocurre, el error no pertenece a la persona, sino al diseño.

Pero el modelo ofrece también una lectura que humaniza la equivocación sin banalizarla. Equivocarse forma parte de la naturaleza humana, pero permitir que un fallo aislado destruya vidas, infraestructuras o instituciones, es una responsabilidad organizacional. El error individual puede ser inevitable; sus consecuencias no. Este planteamiento conduce a un terreno clave: la cultura. Una organización que castiga el error genera silencio. Y el silencio, en entornos donde opera el riesgo, es mucho más peligroso que la equivocación. La teoría del queso suizo exige, por tanto, estructuras donde informar, analizar y aprender no sea una acción audaz, sino un hábito. Los sistemas seguros se construyen con transparencia, no con miedo.

A nivel práctico, la propuesta de Reason se traduce en tres hábitos colectivos: anticipar, mitigar y aprender. Anticipar significa reconocer que el riesgo no desaparece por ignorarlo. Mitigar implica reforzar defensas, pero también comprender cómo se deterioran con el tiempo. Aprender supone revisar incidentes, incluso los que no causaron daños, porque en ellos se esconden las lecciones más valiosas.

La teoría obliga también a convivir con una realidad que a veces resulta incómoda: no existe sistema absolutamente seguro. Incluso los entornos más regulados conviven con una dosis irreductible de incertidumbre. Lo relevante no es aspirar a eliminarla, sino gestionarla con rigor: cartografiar vulnerabilidades, revisar prácticas, someter los procedimientos a la prueba de la realidad y aceptar que la seguridad no es un estado, sino un proceso.

La teoría de Reason plantea una pregunta fundamental: ¿qué valor damos al conocimiento tácito, a la experiencia acumulada y al aprendizaje colectivo? Allí donde se premia la obediencia ciega y se ignora la duda razonada, las grietas se multiplican. Allí donde la mejora continua forma parte del ADN institucional, la vulnerabilidad existe, pero encontrará menos oportunidades para alinearse con el desastre.

La experiencia demuestra que los sistemas realmente seguros comparten cuatro rasgos constantes: claridad en los procesos, responsabilidad compartida, aprendizaje permanente y vigilancia activa. No hay tecnología que sustituya la revisión minuciosa ni liderazgo que reemplace la cultura organizativa. La seguridad es persistencia, más que innovación. Disciplina, más que intuición. Quizá por ello la enseñanza más valiosa del modelo sea la humildad. La humildad de admitir que la perfección no existe, que las organizaciones olvidan, que las rutinas se desgastan y que incluso lo que funcionó durante años puede dejar de hacerlo sin previo aviso.

En términos operativos, esa actitud se traduce en auditorías sinceras, simulacros útiles, foros donde hablar de errores no suponga riesgo reputacional. Cuando el aprendizaje se vuelve cultural y no reactivo, el sistema gana resiliencia. Cuando ese aprendizaje se comparte, el beneficio deja de ser individual y se convierte en estructura.

Pero hay algo más profundo: una dimensión ética que recuerda que detrás de cada procedimiento, cada manual y cada protocolo hay vidas que dependen de decisiones aparentemente pequeñas. La seguridad auténtica no llama la atención cuando funciona. No genera titulares. No se celebra. Simplemente evita tragedias. Y esa silenciosa invisibilidad es, quizá, su mayor logro.

Probablemente surgirán nuevos modelos que complementen o cuestionen la propuesta de Reason. Es natural: los sistemas cambian, y con ellos nuestra manera de pensar el riesgo. Pero su idea central, que los errores son inevitables, pero las catástrofes sí se pueden evitar, seguirá siendo una guía válida mientras existan organizaciones humanas. La teoría del queso suizo no es sólo un modelo técnico. Es una manera distinta de mirar el trabajo, la responsabilidad y la fragilidad. Un recordatorio de que la seguridad se construye desde el aprendizaje. Y que la madurez organizativa no se mide por la ausencia de fallos, sino por la capacidad de impedir que esos fallos se conviertan en tragedias.